1、理解token和tokenizer,可以将其视为解析过程中的关键概念首先,token通常被解释为一种“标记”,它在编程中的作用是标识出源代码中的特定部分,如关键字变量名字符串等语法元素Tokenizer则是一个工具或函数,负责将原始输入如文本流分解成这些有意义的标记,这个过程被称为“令牌化”或“标记;本文分享的是一个高性能的 Rust 实现的自然语言处理分词库 TokenizersHugging Face 公司开源了这款库,其速度和性能都非常出色,能够快速处理大量文本数据对于AI模型的预处理,Tokenizers成为了首选工具,尤其适用于字节级BPE或BERT模型的WordPiece等标记器标记器是自然语言处理中的重要组件,负责将文本;Token是词汇单元,Tokenize是将文本转换为Token序列的过程,Tokenizer是执行Tokenize操作的工具或函数在自然语言处理和文本分析中,Token通常指的是一个最小的有意义的语言单位例如,在英文中,一个Token可以是一个单词,如quotapplequotquotbookquot等在中文中,一个Token可以是一个字,如ldquo我rdquo;在自然语言处理NLP任务中,词Word是最基础的处理单元进入PreTrain时代后,模型处理文本的粒度从Word细分到Token粒度Token可以是字词标识符等如何将文本处理成以Token粒度表示的序列呢答案是需要Tokenizer去将文本切分为Token序列Tokenizer将文本如 quotI love NLPquot 切分为 #39i#39;Tokenize是将文本或语言转化为Token的过程这个过程通常包括将文本按照一定的规则切割成单词标点符号等语言元素,并可能进行一些额外的处理,如去除停用词转换为小写等例如,对于句子quotHello, world!quot,Tokenize的过程可能将其转化为一个Token序列quot#39Hello#39, #39,#39, #39world#39, #39!#39quotTokenizer是。

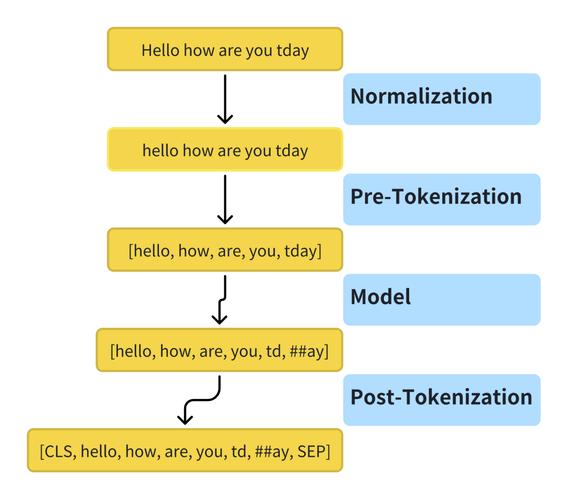

2、Tokenizer是NLP任务中将自然语言文本转换为机器可理解的数字的步骤它是文本预处理的重要部分,通过将文本转化为tokens并使用唯一的tokens生成词汇表,每个tokens在词汇表中的ID作为数字表示该tokentokens可以是单词子单词或字符以下是将文本转换为数字的完整过程,但我们将重点放在tokenization模型阶段基于单词的toke;本系列文章旨在深入探索tokenizer分词器的理论与实践,从训练LLM大型语言模型分词器,到解决使用分词器时可能遇到的疑惑,全方位解答分词器相关问题SentencePiece是一个用于训练分词器的开源库,被LLaMA分词器采用接下来,我们将演示如何利用SentencePiece训练一个分词器首先,需要准备训练语料训练。

3、分词器TokenizerTokenizer在自然语言处理领域中承担将文字转换为索引的任务每个模型都有特定的Tokenizer,其处理逻辑相似使用魔搭的模型库modelscope和训练框架swift,以“杭州是个好地方”为例,通过python调用将文本转为tokens注意,tokens数量可能少于文字数量,因为一个汉字或英文可能被转化为多个;Tokenizer分词算法是NLP大模型基石之一,它能够将文本转化为单独的token列表,以便利用embedding将token转化为计算机理解的向量形式分词算法大致可以分为基于词word基于字character以及基于subword的三类基于subword的分词方式目前较为流行,包含BPEWordPiece和Unigram三种其中,BPE是将文本分割成字符;SentencePiece和WordPiece是两种用于tokenization的工具,它们通过扫描文本生成词表,这个过程可以看作是新词发现词表生成后,会对输入文本进行tokenize,即将文本转化为数字表示的序列,便于模型处理Tokenization是这个过程的名词形式,tokenizer则是实现这一功能的算法或实例,而token则是处理后的基本单元尽管;在探索自然语言处理NLP领域的发展中,文本分析与模型实现的关键步骤之一就是将文本转换为数字,这一过程被称为分词Tokenization分词方式主要有三种类型基于词wordbased基于子词subwordbased和基于字符charlevel在处理大量语言复杂性时,基于子词的分词方法因其灵活性和有效。

4、分词是将文本切分成单词的过程,每个单词对应词汇表中的一项,作为NLP模型输入不同模型可能采用不同分词方式,需用配套工具统一处理文本,以避免token不匹配,影响模型表现分词粒度包含字符级单词级和子词级字符级是最细粒度,词汇表为字符列表,优点是不出现out of vocabulary,但词汇原始,增加上层;token令牌tokenize令牌化tokenizer令牌解析器 2另一种翻译是token可以翻译为“标记”,tokenize可以翻译为“标记解析”或“解析标记”,tokenizer可以翻译为“标记解析器”在编写词法分析器Lexer或语法分析器Parser的时候,除了Lexer和Parser这两个词会经常使用外,tokenize和tokenizer也会经常;tokenizer,或称分词器,其目标是将字符序列转化为数字序列,适应模型输入不同语言的编码方式各异,例如英语通常使用GBK,中文则需UTF8分词策略依据粒度有以下几种Wordbased 每个单词分配一个ID,词汇表大小与语料相关,缺点是可能导致词义相近的词被拆分,如quotcatquot和quotcatsquotCharacterbased。

5、1 理解TokenToken是一种数据结构,它在计算机科学中广泛应用于各种场景,比如在编程语言中代表文本中的一个元素,如关键字标识符或符号2 解释TokenizeTokenize是一个过程,即将文本分割成一系列的Token这个过程通常在编译器的词法分析阶段进行,用于识别源代码中的基本元素3 说明TokenizerT;从LLM输入部分,多样性的编码方式具有灵活性优势,支持成本不高从预测输出角度,多样性的编码方式可能导致信息损失或混淆,干预策略存在成本问题在实际操作中,Hugging Face的tokenizers库质量不错,但某些项目在多核利用与效率上存在问题在LLM时代,大规模语料的处理对tokenizer算法与实现提出了挑战。